スタッフ構成を後で見てもらうと興味深いと思います。現在CM業界ならずマルチメディア展開で躍進中のTYOのHIRO YOSHIDA CEO自らが脚本をてがけ制作、現在ドワーフのCEOとなったNORI MATUMOTOさんがLINE PRODUCERとして若き情熱を注いだ作品でもあります。音響効果を担当した東洋音響 佐々木さんチームは、この時が初めてDAWというシステムで効果音を制作した記念碑でもあります。打ち合わせでこの時に「U-MATICの音声2トラックへ効果音を仕込んできますのであとはそれをシンクロ再生してください」といって私が「これはHD大画面でサウンドは3-2サラウンドでやりますのでそれでは太刀打ちできないでしょう」と返答しましたら、「TVドラマでしょう?」と返ってきたのが印象的でした。それから睡眠時間3時間で約一月のすさまじい!音声制作が始まったと言うわけです。

当時放送は、3-1サラウンドでした。しかしPCM-3348マスターを保管し、そこからデータをHDに移して我が家のPYRAMIXで5.1CH MIXを制作し、それをCPへ試写して3-1よりも改善されていることをアピールして、このマスターは、晴れて今日的な5.1chとしてアーカイブされることになりました。デジタルツールの恩恵は計り知れないものです。96年の第100回AES CONVENTION COPENHAGENでのHDTVとサラウンド音声制作というまだ世の中でHD-TVとサラウンド音声が十分認知されていない中で発表できたのもこの制作に関わったおかげでした。12-28日の放送を見ながら、また同じシーンで涙がでてきました!

MICK SAWAGUCHI 2010-12-31記

日豪共同制作 終戦50周年記念HDTV ドラマ

「最後の弾丸」3-2サラウンド 制作 1995-06 HDV-520 STUDIO MIX 95-08-13 放送 BS-HI

[ はじめに ]

この作品は、終戦50周年を記念して、NHKとオーストラリア「9CH」の作品として、監督以下オーストラリアの映画人が制作した90分のドラマです。

HD-ハンディカメラの無い時代にスタジオHDカメラと中継基地を設営しての過酷なしかし挑戦的な制作として国内外で多くの受賞もした作品です。

当時のTD/HDVEであった苗村、松林コンビの努力は、賞賛に値します。95%がオーストラリアのジャングルで95年2〜3月ロケーションされ、オフライン編集までをオーストラリアで行い、オンライン編集と音声ポストプロダクションがNHKで行われた、まさに様々なスタッフが参画をして作り上げられたドラマといえます。

1 ガイジンとチームを組み成功するためのポイント

Re-Mix note to Mick Sawaguchi 26th June 95

Director of Last Bullet Michal Pttinson

MP wish to re-adjust some spot sound . rest of those were very fine.

Reel-1

1 Reception Scene

Louder more thunder and heavy rain .

2 Track interior

Creaking more and feel bump .

3 Banzai Attack

Banzai of loop group wish to listen one shot earlier over Stanley close-up .

4 Stanley stand up

Thunder to crossover on to Yamamura's photo.

5 Jane [you dead]

Put reverb on voice. make it dream like.

6 Borneo Village

More atomos less chooks.

7 Atomos as patrol walk into ambush

Put same atomos no water FX.

8 Yamamura's gun shot

Less reverb and more crack.

9 Stanley shoot Kuroki

1 shot only and more crack.

10 Kuroki's rifle

Sound feel far away more close,bright sound.

11 Ricochet sound off log

Cut it seems to be crochet.

12 Stanley behind log it end of R-1

Cut surround atomos.

13 Stanley hooked his gun

Put clink touch sound since Yamamura what's hear .

14 Yamamura's gun shot slow motion R-2

More delay on Yamamura's bullet.

15 Yamamura's gun shot at R-1

More bigger sound it hit sandbag .

いきなり英文の議事録がでてきましたが、これは今回のドラマ「最後の弾丸」のプリMIX終了時点での監督の要望のノートです。

我々日本人が共同制作をする上でどんな点に注意すれば成功裏に共同プロジェクトを遂行できるかを私の経験則から述べてみたいと思います。93年に「山田が街にやってきた」でイギリスクルーと94年は「8月の叫び」でチェコのクルーとドラマ制作を経験しましたが、いずれも監督以下メインスタッフは、NHK側でした。今回のスタッフ構成が大きく前者と異なるのは、まさに95%監督以下ガイジンという構成で、初顔合わせの仕事と言う点です。ではプロジェクトが成功するためのポイントをあれこれ・・・・・

1-1 契約条項の中で、自分の役割は何か?を明確に

1-2 あれこれ文化Vs Exactly文化----ノートによる確認

1-3 Silence is not a golden !-----コミュニケーションを

1-4 自分を分からせる---分かってもらう待ちの姿勢をやめる

1-5 日本人の美徳 気配り 先読み行動は慎重に

1-6 ジョークで明るいスタジオ

1-1 契約と自分の役割の確認ということは、自分がこのプロジェクトにどのような形で参画できるのか?また何をして欲しいと明記されているのかを個人的な思いこみだけで判断しないようにするということです。

我々はいきおい、思いこみが先行する民族のため契約条項などは、深く確認もせず、音声担当といわれると、すぐに自分がミクサーをやるものと思いこみ、いざ仕事が始まると、実はミクサーは向こうのスタッフにいて、我々には機材のメンテナンスやシステム管理を頼んでいた。と言った事例があります。こうしたスタート段階のつまずきは、後々までしこりとして残り結果としてプロジェクトがうまく機能しないといった現象を生じがちになります。

また自分はどんな権限があるのかどうかもポイントです。

指示をだしても効力があるのか、または単なるアドバイザーとして参考意見以上の権限は持たないのか?と言った点です。一人一人の役割が厳格に規定され、その範囲内でプロフェッショナルとして能力を発揮するという考えに好き嫌いを別にして慣れる必要があるということですね!

1-2 あれこれ文化Vs Exactly文化----ノートによる確認

“曖昧な日本人“ということばが今年ノーベル賞でキャッチコピーとなりましたが、何事もアウンの呼吸で分かり合える優れた民族性を持つ我々に対して何事も事細かに、具体的な数値やデータで表現しなければ分からない民族がいっしょに仕事をすれば、どうしても我々の思考方法は、不思議に受け取られてしまいます。例えばミクシングの表現を例にしてみましょう。

「あそこをこんなふうにガーと盛り上げるのがいいよね」「さっきのタイミングはもう少し上げかな」「あれとこれを混ぜてちょっとレベルを落とせば良くなるね」・・・・こう言った会話は、彼らにとって何の意味もありません。

そこで、あらゆることがタイムコードベースで表され、何時何分何秒何フレームから何時何分何秒何フレームまでを+3dBアップ、とか1フレーム遅らせるといった具体的な表現をしなければなりません。

また各制作段階では、監督と打ち合わせやスケジュール、本日の作業予定などを議事録として文書にし、双方が確認をして合意の上で次に進む・・・・と言った段取りのクセをつけておかなくてはなりません。

先に挙げた英文は、彼らがクリエーティブ ノートと呼ぶメモの一例です。

今回は、映像のオンライン編集が終わった段階で、作品全体のサウンドデザインを監督がどうしたいかを我々音声スタッフと打ち合わせたメモ。

プリMIXが終了しファイナルMIXへ行く前の、プリMIX メモ。

作曲家ネリダ・タイソン・チューさんは彼女独自で監督と打ち合わせた音楽構成についてのメモ。

それに毎日のミクシング作業工程メモをつくりました。

映画の世界では、監督中心主義ですので、監督が全てを掌握しておきたいという欲求を我々も無視してはトラブルの原因になりますのでご用心を・・・!

1-3Silence is not a golden !-----コミュニケーションを

無口で黙々と仕事をやる・・・というのが我々の美学とされてきました。

しかし、ガイジンと一緒となるとこれは、不信感を招く要因以外の何者でもありません。彼らがスタジオにいる場合は極力彼らに今何をやっているのか、どこまで行っているのか、何が原因で時間を食っているのか、トラブルがあればどんな解決方法を取ろうとしているのか・・・・といったことを周知しながらスタジオワークを進めなくてはなりません。ついついおっくうになったり、後ろで見ていれば分かるだろう。といった一人合点は禁物です。

今回こんな行き違いがあり、あやうく一足即発の事態になるところだった例をひとつ・・・・・。

ADRテープ(アフレコが録音されたDATテープ)がイギリスとオーストラリアから届き、我々はタイミングの調整をとるのにamsのオーディオファイルにコピーするのが作業として能率的であろうと判断し。コピー作業を始めました。

その間私は何もないので、連日の疲れもあり、ソファーでのんびりしていました。それを見た監督のマイケル・パッチンソンは、我々が何もしないでスタジオを遊ばしてゴロゴロしていると判断し、突然不信感を露にした態度で、抗議を始め、コピーをしていた担当者一同シラーとする事態となりました。

ですから、今やっていることは何で、とかこれから作る音について、自分としてはこう考えながら組み立てていきたいと思うが監督としては、どう思うか?

といったコミュニケーションを逐一計りながら作業を進めるのがスムースで良い結果を生むということを体験しました。

1-4自分を分からせる---分かってもらう待ちの姿勢をやめる

これも我々日本人の謙譲の美徳のひとつですが・・・・

積極的に自分をアピールすることを嫌います。そんなことをせずとも時間がたてば自分がどんな人間か分かってもらえる・・・という受け身の姿勢が強いからです。長い間同じ人間とじっくりつきあう農耕民族の我々。しかし彼らは、一度会った段階で、相手の全貌を知りたいという行動特性があります。要するにこの相手は自分の作品を委せるに足る十分な資質を持っているのかどうかを即判断したいわけです。ですから、我々日本人どうしであればなんと厚顔な自己宣伝にたけた奴か・・・と思われるくらいにまず初対面の段階で自己アピールをしておくことが大事です。

自分の特徴や専門性、他の人に比べてどんな能力を持っているのかをまず始めに分からせる努力を自ら積極的に行うということです。また、海外の同業仲間などで友達がいればそんなことも話しておくと意外なところで繋がりが有ったりもする場合もでてきます。どんな業界も特殊で「SMALL WORLD」だといえるからです。今回偶然にもオーストラリアのDAWメーカでエディ・トラックというメーカのオーナーと監督のマイケルや作曲のネリダさんが友人で、その彼と私は、92〜3年頃のAESコンベンションで何度か話をしたという機会がありました。マイケル達が今度NHKで仕事をするんだと話したところ「俺はNHKなら沢口というミクサーを知っている」という話題になり、お互いの接点があったことで、初期段階のコミュニケーションが大変スムースになりました。

またネリダさんは、少し日本語が話せるので、こちらも親しみが湧き、いきおい世間話もティー、ブレイクに楽しむといったことができます。ガイジンも日本語の基礎会話くらいを勉強しておいてほしいものです。我々も苦労しながら彼らの言葉で意志疎通をはかっているのですから・・・・

ネリダさんは、オーストラリア人は、家族や家庭の話題をもちだすのを楽しむのだそうですが、相手がアメリカ人の場合は、絶対に話題にはしないそうです。

病めるアメリカのひとつの側面かもしれません。

彼女には、映画音楽の構成や今回のドラマの音楽の構成など、またいわゆる業界用語などを尋ねてみましたがとても親切に話しをしてくれました。

ひとりでスタジオに孤立感だけを感じるような空気にしないということもとても大切です。彼らもスタッフの一人としていつも参画したいと言う気持ちに変わりはありません。彼女は、アメリカの映画音楽家でジェリー ゴールドスミスという人がいますが、彼の元で映画音楽を勉強し、今はオーストラリアでTVや映画、テーマパークといった仕事をしているそうです。オーストラリアでも長編映画制作は年に2〜3本程度に減ってきており、優秀なスタッフもあまり仕事がない状況だといっていました。彼女は今回自費で来日し我々のMIXに参加をしているのですが、自分の音楽がどういじられるのか不安もあったでしょうし、これがヒットすれば彼女の音楽に今以上の要請がくるというチャンスに賭けてもいるのです。一度のチャンスを大切に、そこで出会った人たちとの出会いも大切にというのが基本にあるように感じます。

1-5 日本人の美徳 気配り 先読み行動は慎重に

我々は、周囲の状況を的確に判断してすばやく次の予測行動がとれる優秀な民族であることを誇りにできます。しかし、そうした思考性向のない人々にとってこの行動は、不信と懐疑をもたらす何者でもありません。

トラブルを起こさないためには、必ず彼らに事前に説明をして、そうした行動にでる必然性を納得してもらわなければなりません。彼らのプロ意識というのは、自分が与えられた範囲で与えられた要求を100%実現することにあります。我々の気配りは、いわばその領域を時として踏み越える行動になります。

親切のつもりが、あいてのプライドを傷つけたり、と言った事態になり、こちらは、“何だ親切でやってやったのにあの態度は”とおもい相手は、“自分の領域を勝手に犯す失礼な奴だ”と憤慨することになります。

国内で一部ロケがありましたが、監督のマイケルと撮影監督のロジャーは、撮影が終わると、車に乗り込んでさっさとホテルに引き上げてしまいます。

これが日本人だけのクルーであれば、きっと翌日から監督のいじめが始まることでしょう。“なんだ撤収を手伝いもしないで自分だけ帰ってしまうなどとんでもない”と言う感情からです。しかし彼らのルールではそれはそれぞれの専門家が自分たちの受け持ち範囲を完璧にこなせばそれのほうがいいのだ!という考え方です。こんな例もあります・・・・・海外のスタジオで録音をした日本のミクサーが撤収を手伝おうとフロアーのケーブルを巻き始めたところ。フロアー専門のスタッフから「あなたは我々の仕事を奪うのか」と抗議されたとか、自分たちの仕事が早く終わったのではかの機材撤収を手伝おうと、手をかけるとやはり迷惑そうな顔をされたとか、部屋の周りが汚いので掃除をしようとしたところ、掃除担当の人から抗議された・・・等などどうも気配りがマイナスに働くケースのほうが多いようです。これは言葉の問題もあり、我々がなにもいわずいきなりそうした行動にでることも原因のひとつです。必ず相手に状況を分からせてから行動に出るという鉄則をひとつ。

1-6 ジョークで明るいスタジオ

ネクラのプロはあまり好まれません。スタジオの雰囲気はいつも明るく。

といってもラテン系の人たちのように重大な過ちがあっても“ノープロブレム”を連発されるのもこまりますが・・・

日本コロムビアの穴澤さんに聞いた話ですが、フィリップスレコードのスタッフたちは、いつも一人ひとつの小話やジョークの披露合戦をやるそうで、そんな中に日本人が真面目一路で参加すると実に気まずい雰囲気になるといっていました。仕事の腕だけがよいというのは、かれらからみるとまだ完成されたプロとみないのでしょう。自分を印象づけるためにもまた時に落ち込みそうな仕事になるときもこの明るいジョークで乗り切りましょう。

今回の本論音声編を紹介したいとおもいます。

2 3-2/3-1ステレオのマルチマスター制作

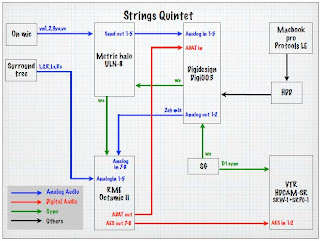

HDTVのVTRは、8トラックのマスター音声が記録できます。これを有効に利用するためにはどのようなMIX をしておくのがよいか検討した結果私は、HDTVで制作したソフトの多メディア応用が可能な階層構造を持つマスターつくりとして以下のようなフォーマットで行うことにしています。

* 映画/イベント会場での再生方式 3-2サラウンド

* ハイビジョン放送方式 3-1サラウンド

* 現行ステレオ再生方式 2チャンネルステレオ

ですから、HDVTRには

1-CH L

2-CH R

3-CH C

4-CH S

5-CH S-L

6-CH S-R

7-CH Lt

8-CH Rt

と言った内容でマスタリングされ、ここからメディアに応じて使い分けが行えるようになります。大画面には、サラウンド これが原則です。

3 制作の流れ

3-1 プリプロダクション

基本はドラマ制作の一般的な流れと同じです。同録素材は、オーストラリアのプロダクション ミクサーのDATテープと録音シートをたよりに、必要とおもわれる素材をAMS-オーディオファイルにコピーしこれらは5インチのMO-ディスクで保存されます。

一方効果音は、チャンネル数の多いフェアライトMFX-3(16-ch)にワークのVCR タイムコードを元に素材を張り付けていきます。これも5インチMOディスクで保存されます。プリMIXが終了すると、フォーリー録音を行います。今回はていねいな音が欲しいとのマイケル監督の要望で、極力同録にあるアクションノイズでもさらにそれを補強する素材を多く録音しました。またライフルスコープ越しに見える松葉杖の少年の足音や雨で曇ったスコープを擦る音、落ち葉を払うと表れる蟻の足音、戦死者の死体にそよぐ竹笹や水音、狙撃する際の銃が塹壕の銃眼にこすれる音といったかすかな気配を注意して表すことにしました。

今回初めて仕事をした東洋音響の佐々木さん達は、映画でのフォーリー録音に豊富なキャリアをお持ちで、ひとつの音に4人が小物を分担して手際よく雰囲気を作り上げていきます。最近若い効果の人たちが、選曲や出来合いのCDから切り出して組み合わせることに意義を感じている傾向がみられますが、こうして本来の手作りで録音された生音ややはり力があります。

これも録音は、フェアライトのMO-ディスクにタイムコードとともに録音しました。同録 効果音の準備には我々のプリープロルームである、AP-812とAP-818を使用して10日間行いました。

3-2 プリMIX

各素材が仕込まれた段階で、音の加工合成を行うプリーMIXとなります。これにはCD-809でおもにベースノイズ系をそしてハイビジョン専用のポストプロダクションスタジオHVD-520へはいってからサラウンド系と同録の整音、国内分のアフレコ、をまとめる段取りとしました。HVD-520 では、メインのモニターをチャンネルあたりピンクノイズで、85dB、隣接プリプロルームの小型サラウンドモニターを83dB、そしてゲストルームにある一般TV用の小型ステレオモニターを78dBに規定してバランスの確認をすることにしました。これは前回の3-2MIX「8月の叫び」と同様です。

3-3 3-2サラウンドのデザイン

今回は、ジャングルの中の狙撃兵と生き残ったオーストラリア兵の1対1の駆け引きが中心です。サラウンドは、雨や雷、ジャングルのアンビエンスといった自然な雰囲気表現と前半の日本軍の万歳アタックの戦闘シーン、日本の狙撃兵山村の銃声のひろがり、そして回想や夢で出てくる声の表現とにわけてつかいました。

狙撃戦となる2人の切り返しを一方はサラウンドでもう一方はアップのモノーラルでとプリMIXで作ったのですが、マイケル監督から、これはお前のBIG TOYで人々を混乱させるだけだといわれやむなくサラウンド分は押さえることにしました。

3-4 MIX- ダウン

ミクシングのトラックシートを示します。HVD-520のコンソールはAMS/NEVEのLogic-2でこのオートメーションを活用してMIXが行われました。

私は規模の大きな作品は、2man MIXを採用しており今回も、私が台詞と音楽を東洋音響の小川さんが膨大なチャンネル数になる効果音を担当し進めました。音楽はL-C-R-Sの4-ch MIXでTASCAM DA-88にタイムコード付きで持ち込まれていますのでこれは単純にロックをとればOKです。今まで音楽はステレオ仕上げしか経験がありませんでしたので、台詞や効果音が入ることで特に音楽のセンターとサラウンドのレベルをフォローしなくてはならず「なるほどアメリカが3ーマンMIXをやるわけはここらへんかな・・・」と実地訓練で納得する状況もありました。

ミクシングの段取りは、以下のようにし数分単位のブロックでメモリーしていくことにしました。

* まず土台になる台詞トラックをOK に仕上げる。

* 次に音楽を固める。

* 効果音トラックを固める。

* 全体を3カ所のモニターで聞いてバランスチェック。

* 再度修正

* もう一度3カ所で聞いてOKなら次のブロックに進む。

この方法はあまり日本人に馴染みません。というのは全体をコントロールするのではなくひとつひとつを積み上げて、また修正するという方式だからです。我々は一気呵成にいきおいや流れのリズムを重視し、こうした細切れのMIXでは自分の流れが出来にくいと判断してきたからです。生放送という歴史を持つ放送制作では特にそうしたことがディティール以上に重視されてきました。

しかし、粘っこい彼らの論理は、ディティールの積み上げなのです。

ですからコンソールにもコンピュータアシストは必要不可欠の要素なのです。

あれは腕に自信のないやつが使うものだという傾向の強い国内の状況とも違います。でもそうやって細切れにMIXしてもいつも全体の設計を計算していればリズムをぎくしゃくすることもありません。現実にそうした作品が世界中でヒットしているわけです。

[ おわりに ]

原案構想から3年。準備から1年をかけて具体的な形になった本作品は、これまで当然のように行われてきた自社内完結主義から、それぞれの分野のエキスパートが参画してプロジェクトを組んで制作を行うという体制で行われました。これは、永年NHKで国際共同制作を担当してきたNOBUO ISOBE CPの哲学でもあります。すなわち放送という限られた条件下でベストであればいいといういいわけが通用しないメディア制作者が日本でも育って欲しいという思想です。わたしにとってもそのことを監督やスタッフから十二分に体験できましたし、音の責任はすべて引き受けると言う責任感を育成するのにも役に立ちました。最後に関係スタッフを紹介してお礼に変えたいと思います。(沢口真生 記)

[ 音声スタッフならびに関係者 ]

ミクサー 沢口真生(NHK)

アシスタント 会田裕二(NTS)

音響効果 佐々木英世 小川広美(東洋音響)

DAW フェアライト指導 岩崎進(NHK)

HVD-520 エンジニアリング 嶽間沢彰

監督 Micheael Pattinson

音楽 Nerida Tyson Chew

制作 吉田博昭(TYO)

Georgina Hope

Cris Noble(9-CH)

磯部信夫(NHK-HV)

制作補 松本紀子(TYO)

Mark Baron

広島発サラウンドドラマ「火の魚」:実践5.1ch サラウンド番組制作

「サラウンド制作情報」 Index にもどる

「サラウンド入門」は実践的な解説書です